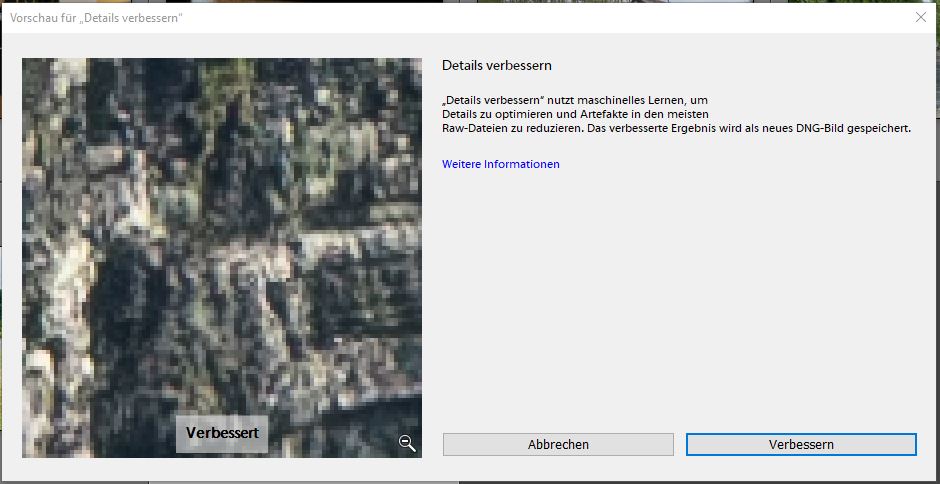

Wenn man nicht gerade die Pressemitteilung von Adobe zu den normalen Updates von Lightroom Classic CC liest, kann man diesen kleinen aber feinen Menü-Eintrag sehr leicht verpassen: Enhance Details, oder – wie es in der deutschen Oberfläche heißt – Details verbessern. Dieser versteckt sich hinter dem Rechtsklick auf ein Foto oder der Tastenkombination STRG+ALT+I.

Was sich hinter diesen Informationen verbirgt klingt wie eine Mischung aus Raketenwissenschaft und Zukunftsvision: Ein neuronales Netzwerk, trainiert durch Machine Learning, verbessert die RAW-Daten unserer Kamera (und es geht ausschließlich mit RAW-Daten) in die Bilder, die wir am Ende sehen. Das Ganze funktioniert übrigens für jeden Hersteller und jedes Modell.

Natürlich haben wir uns diese Funktion für euch angeschaut.

Bei der ersten Verwendung von Enhance Details stellt man eins direkt fest: Dieser Schritt ist definitiv nicht für jeden Schnappschuss gedacht. Adobe merkt dies auch in ihrer Pressemitteilung an, aber die Praxis weiß dann doch zu überraschen. Deutlich über eine Minute hat das Verbessern eines einzelnen Bildes gekostet – auf einem PC der letztes Jahr noch brandneu war. Das Ergebnis des Prozesses wird in eine neue Datei geschrieben – der Prozess zerstört also nicht das Original – die entscheidend größer ist als die Quelle. Zum Teil konnten wir den Faktor 3 (33MB à 90MB) beobachten. Wahnsinn.

Der Algorithmus verlässt sich übrigens extrem auf die Grafikkarte des Systems. Eine gute, vorzugsweise externe Grafikkarte ist also von Vorteil und entscheidend bei der Frage nach der Geschwindigkeit.

Letztendlich bedeutet das, dass man Enhanced Details nicht mit einem normalen Bearbeitungsworkflow verwechseln sollte. Hat man seine Bildauswahl getroffen und möchte die finalen 3 Bilder für den Kunden aufbereiten oder für das Fotobuch exportieren, dann kann Enhanced Details angewandt werden. Zur Qualitätsverbesserung ausgewählter Aufnahmen eben. Es wird wohl für niemanden der Normalfall der Bearbeitung werden.

Aber nun zur alles entscheidenden Frage: Was bringts?

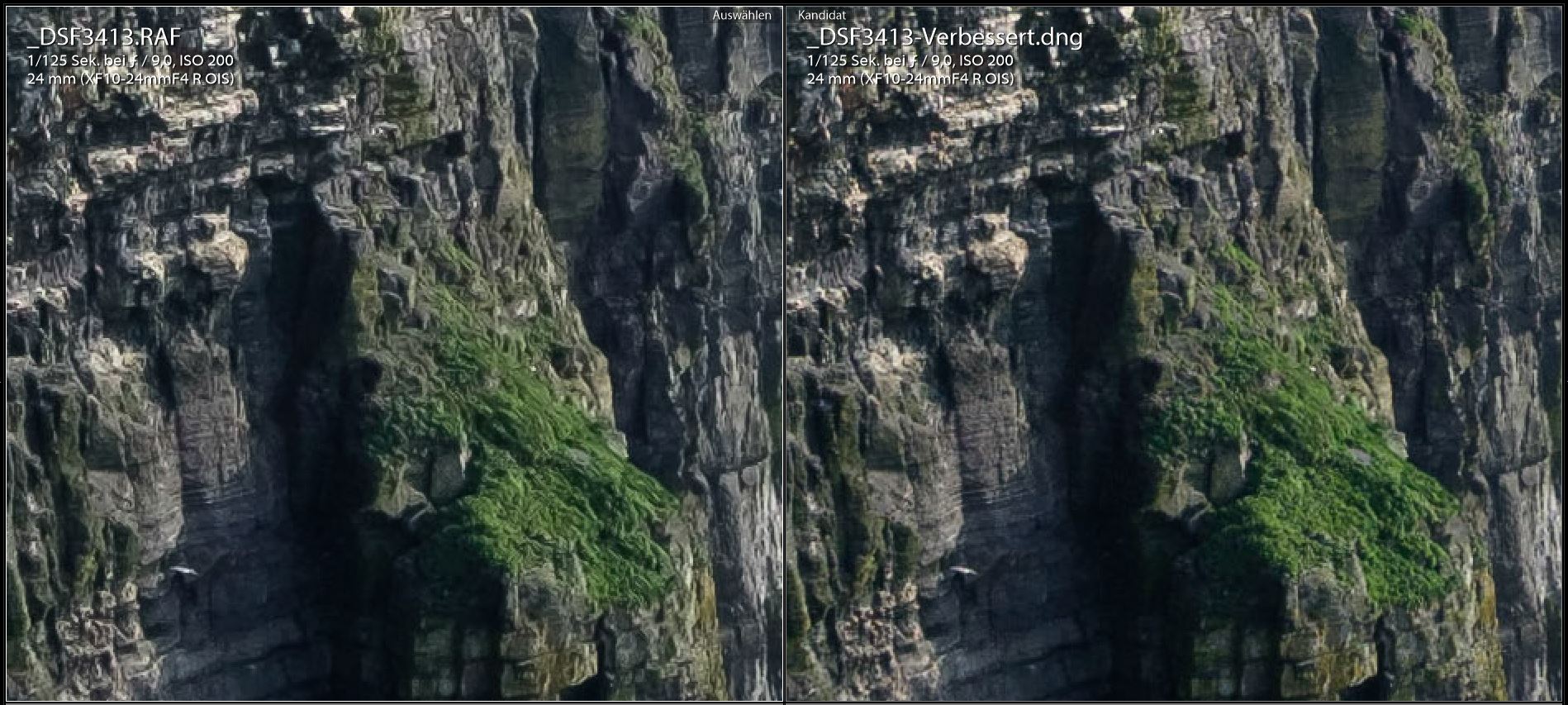

Zugegeben: Man muss nah ran zoomen und genau hinschauen, aber dann gibt es Unterschiede. Betrachten wir z.B. den grün bewachsenen Bereich im rechten Teil des Bildes. Oder die hellen Felsstrukturen oben links. Hier ist ein deutlicher Unterschied zu erkennen, und für mein Empfinden hin zum Besseren: organischer, natürlicher, in den Details feiner. Es funktioniert also tatsächlich.

Unsere Tests zeigen aber auch: Unterschiedlich gut. Es sind gerade die feinen und klaren Strukturen – Blätter, Fenster in Stadtpanoramen – bei denen der Algorithmus glänzt. Bei einer Langzeitbelichtung am Strand hingegen kann man sich eher Zeit und Speicherplatz sparen. Und auch die große Betrachtungsnähe zeigt schon: Eher großformatiges profitiert von den verbesserten Details: Poster, Fernseher, Plakate. Die Unterschiede in kleineren Formaten wie Handy, Web oder 9×13-Abzug eher nicht, zumindest aber kaum merklich.

Noch eine gute Nachricht: Auch wenn der Algorithmus manchmal keine Vorteile bringt, so bringt er doch nie Nachteile. An keiner Stelle konnten wir ein destruktives oder fehlerbehaftetes Verhalten erkennen.

Ist diese neue Funktion also eine Revolution? Teils Teils. Es ist schon beeindruckend, was durch eine veränderte Herangehensweise aus den bestehenden Daten herausgeholt werden kann. Gerade im professionellen oder auch privat großformatigen Bereich wird diese Funktion viel Wert sein. Soweit zum revolutionären Teil. Gleichzeitig muss man aber feststellen, dass diese Funktion nicht – im wahrsten Sinne des Wortes – alltagstauglich ist. Dateigröße, Workflow, Bearbeitungsdauer – all das spricht gegen einen übermäßigen oder einfach nur prinzipiellen Einsatz der Funktion. Und zum jetzigen Zeitpunkt ist es das, woran die Funktion für den ganz großen Wurf noch hakt. Für eure private Galerie solltet ihr es aber in jedem Fall einmal ausprobieren.

Hinterlasse einen Kommentar

Du musst angemeldet sein, um einen Kommentar schreiben zu können.